マルチクラウド環境でのサーバーレスアーキテクチャ実践ガイド:コスト削減と可用性向上の両立

マルチクラウドとサーバーレスの組み合わせが注目される理由

近年、クラウドサービスはビジネスのデジタル変革に欠かせない存在となっています。その中でも特に注目を集めているのが「マルチクラウド」と「サーバーレス」というアプローチの組み合わせです。「すべての卵を一つのカゴに入れるな」という古い格言がある通り、複数のクラウドプロバイダーを活用しながら、インフラストラクチャの管理から解放されるサーバーレスアーキテクチャは、多くの企業にとって理想的な選択となりつつあります。

マルチクラウド戦略のメリットとビジネスへの影響

マルチクラウド戦略を採用する主な理由は、以下のようなメリットが得られるからです:

ベンダーロックインの回避: 単一のクラウドプロバイダーに依存することで生じるリスクを軽減できます。これにより、将来的な移行コストの削減や、価格交渉力の向上につながります。

高可用性の実現: 異なるクラウドプロバイダー間でワークロードを分散することで、単一障害点を排除し、サービスの継続性を確保できます。

# 可用性の計算例

単一クラウドの可用性: 99.99%(年間ダウンタイム約52分)

独立した2つのクラウドを活用した場合: 99.99% × 99.99% = 99.9999%(年間ダウンタイム約30秒)最適なサービスの選択: 各クラウドプロバイダーが得意とする領域のサービスを選択的に利用することで、パフォーマンスと機能面での最適化が可能になります。

コンプライアンスとデータ主権への対応: 地域ごとに異なるデータ規制に対応するため、データの保存場所をコントロールできます。

ビジネス面では、マルチクラウド戦略の導入により、2025年のGartnerの調査によると平均で15-20%のクラウド支出削減が達成されています。また、障害発生時のビジネス継続性確保による機会損失の防止は、年間数千万円から数億円のリスク軽減効果をもたらすと報告されています。

サーバーレスアーキテクチャの進化と現在の立ち位置

サーバーレスアーキテクチャは、2014年にAWS Lambdaが登場して以来、急速に進化してきました。現在では単なる関数実行環境としての枠を超え、以下のような発展を遂げています:

サーバーレスコンテナ: AWS Fargate、Google Cloud Run、Azure Container Instancesなど、コンテナのサーバーレス実行環境が普及しました。

サーバーレスデータベース: DynamoDB、Cosmos DB、Firestoreなど、自動スケーリングするデータベースサービスが充実しています。

イベント駆動型アーキテクチャの標準化: CloudEvents仕様の普及により、クラウド間でのイベント連携が容易になっています。

// CloudEventsフォーマットの例

const cloudEvent = {

specversion: "1.0",

type: "com.example.someevent",

source: "/mycontext/subcontext",

id: "A234-1234-1234",

time: "2018-04-05T17:31:00Z",

datacontenttype: "application/json",

data: {

appinfoA: "abc",

appinfoB: 123,

appinfoC: true

}

};- サーバーレスオーケストレーション: AWS Step Functions、Azure Durable Functions、Google Workflows等、複雑なワークフローを管理するサービスも登場しています。

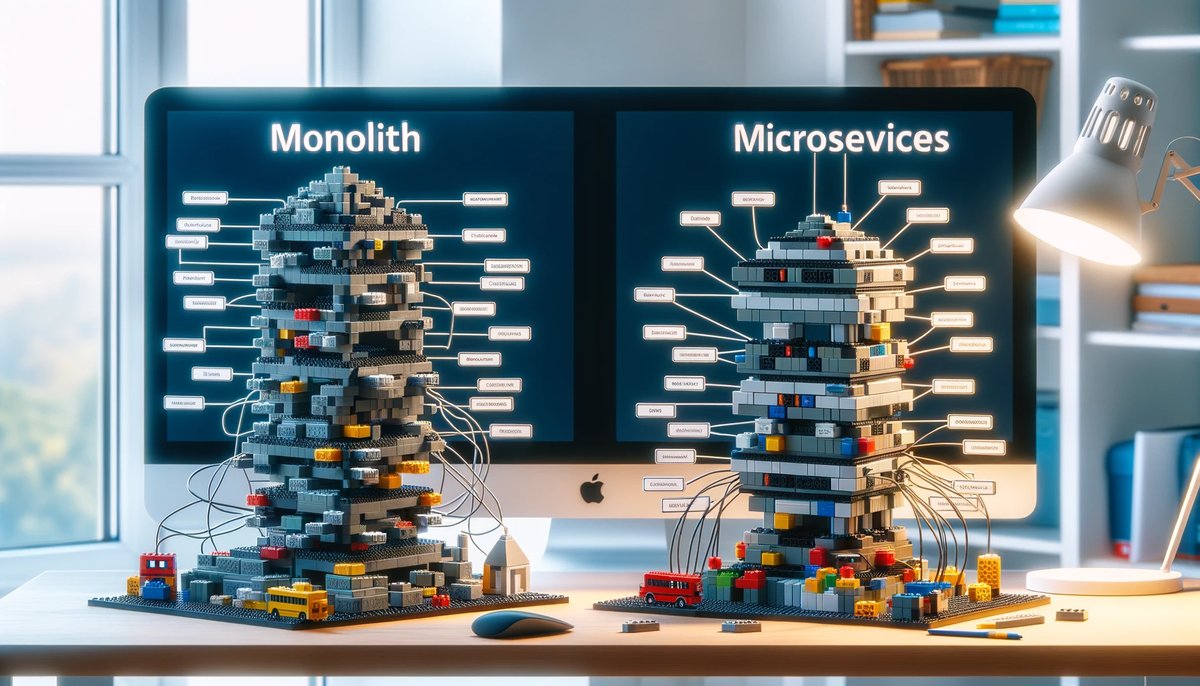

現在、サーバーレスアーキテクチャは初期のパイロットプロジェクト段階を超え、エンタープライズレベルでの本格採用フェーズに入っています。2025年には企業のクラウドアプリケーションの約50%がサーバーレスアーキテクチャを採用すると予測されており、特にマイクロサービス化の進む現代のアプリケーション開発において中心的な役割を果たしています。

このトピックはこちらの書籍で勉強するのがおすすめ!

この記事の内容をさらに深く理解したい方におすすめの一冊です。実践的な知識を身につけたい方は、ぜひチェックしてみてください!

主要クラウドプロバイダーのサーバーレスサービス比較

マルチクラウド環境でのサーバーレスアーキテクチャを構築するには、各クラウドプロバイダーが提供するサービスの特徴を理解することが不可欠です。それぞれのプラットフォームが持つ独自の強みと制約を知ることで、最適な組み合わせを実現できます。

AWS Lambda、Azure Functions、Google Cloud Functionsの特徴と違い

3大クラウドプロバイダーのサーバーレス関数サービスの主な特徴を比較してみましょう:

| 特徴 | AWS Lambda | Azure Functions | Google Cloud Functions |

|---|---|---|---|

| 実行時間上限 | 15分 | 最大60分(消費プラン) | 60分(第2世代) |

| コールドスタート | 一般的に速い | Premiumプランで改善 | 第2世代で大幅改善 |

| サポート言語 | Node.js, Python, Java, Go, .NET, Ruby | Node.js, Python, .NET, Java, PowerShell | Node.js, Python, Go, Java, .NET, Ruby, PHP |

| トリガー種類 | 70種類以上 | 多数のバインディング | HTTP, Pub/Sub, Firestore, Cloud Storage, など |

| 料金モデル | 実行回数と実行時間 | 実行回数と実行時間 | 実行回数と実行時間 |

| ローカル開発 | AWS SAM | Azure Functions Core Tools | Functions Framework |

実際のコード例を見ると、それぞれの特徴がよくわかります:

AWS Lambda (Node.js)

exports.handler = async (event) => {

console.log('イベント:', JSON.stringify(event, null, 2));

// イベントからデータを取得

const message = event.Records[0].Sns.Message;

// 処理を実行

const result = `処理結果: ${message}`;

return {

statusCode: 200,

body: JSON.stringify({ message: result })

};

};Azure Functions (Node.js)

module.exports = async function (context, req) {

context.log('HTTP関数が処理を開始しました');

const name = req.query.name || (req.body && req.body.name);

const responseMessage = name

? `こんにちは、${name}さん!`

: "リクエストにnameを渡してください";

context.res = {

status: 200,

body: responseMessage

};

};Google Cloud Functions (Node.js)

exports.helloWorld = (req, res) => {

const name = req.query.name || req.body.name || 'World';

res.status(200).send(`Hello ${name}!`);

};パフォーマンス面では、2025年の最新ベンチマークによると、AWS Lambdaがコールドスタート時間において優位性を持ちますが、Google Cloud Functions第2世代も大幅に改善されています。メモリ割当量と実行速度の関係では、すべてのプロバイダーが線形的なスケーリングを示していますが、計算負荷の高いワークロードではAzure Functionsの優位性が見られます。

クラウドプロバイダーごとの強みと弱みを理解する

各クラウドプロバイダーには特有の強みと弱みがあり、これらを理解することでマルチクラウド戦略を最適化できます。

AWS

- 強み:

- サーバーレスエコシステムの成熟度と幅広さ

- Step Functionsによる堅牢なワークフロー管理

- CloudFormation/SAMによるInfrastructure as Code

- 弱み:

- VPC内でのLambda実行時のコールドスタート問題

- モニタリングとデバッグがやや複雑

- 15分の実行時間制限

Azure

- 強み:

- Durable Functionsによる強力なオーケストレーション

- .NET言語との緊密な統合

- Logic Appsとの連携によるノーコード/ローコード開発

- 弱み:

- ドキュメントと例が他と比べて少ない

- リソース管理の複雑さ

- コールドスタートがやや遅い(Premiumプラン以外)

Google Cloud Platform

- 強み:

- シンプルな設計と使いやすさ

- Cloud Run(サーバーレスコンテナ)との統合

- データ処理と分析サービスとの連携

- 弱み:

- トリガーの種類が他と比較して少ない

- マネージドサービスの種類が比較的少ない

- エンタープライズ向け機能が発展途上

マルチクラウドサーバーレス戦略を立てる際は、「単一プロバイダーで全てを行う」のではなく、「各プロバイダーの強みを活かす」アプローチが効果的です。例えば、データ処理パイプラインにはGoogle Cloudの強みを、ミッションクリティカルなAPIにはAWSの安定性を、社内システム連携にはAzureの企業向け機能を活用するといった組み合わせが考えられます。

「インフラ構成も馬車から飛行機へと変化した。馬車をより速くしようとしていた時代から、まったく新しい移動手段を考える時代へと変わったのだ」というアナロジーで表現されるように、サーバーレスアーキテクチャはこれまでのインフラストラクチャの考え方を根本から変えるものです。この変革の波に乗るには、各プロバイダーの特性を理解し、最適な組み合わせを見つけることが鍵となります。

このトピックはこちらの書籍で勉強するのがおすすめ!

この記事の内容をさらに深く理解したい方におすすめの一冊です。実践的な知識を身につけたい方は、ぜひチェックしてみてください!

マルチクラウドサーバーレスアーキテクチャの設計パターン

マルチクラウド環境でサーバーレスアーキテクチャを構築する際には、クラウド間の連携と責務分担を明確にする設計パターンの選択が重要です。適切なパターンを採用することで、各クラウドの強みを活かしつつ、システム全体の堅牢性と保守性を高めることができます。

イベント駆動型アーキテクチャの実装アプローチ

イベント駆動型アーキテクチャは、サーバーレス環境と相性が良く、マルチクラウド構成にも適しています。このパターンでは、システムの各コンポーネントが「イベント」を発行/購読することで疎結合な連携を実現します。

マルチクラウドでのイベント駆動アーキテクチャの実装例:

// AWS SQSからAzure Functionsにイベントを伝搬する例

const AWS = require('aws-sdk');

const axios = require('axios');

exports.handler = async (event) => {

// SQSからのメッセージを処理

for (const record of event.Records) {

const message = JSON.parse(record.body);

// Azure FunctionsのHTTPトリガーにイベントを転送

try {

await axios.post(process.env.AZURE_FUNCTION_URL, {

source: 'aws-sqs',

timestamp: new Date().toISOString(),

data: message,

correlationId: record.messageId

}, {

headers: {

'Content-Type': 'application/json',

'x-functions-key': process.env.AZURE_FUNCTION_KEY

}

});

console.log(`イベントをAzure Functionsに転送しました: ${record.messageId}`);

} catch (error) {

console.error('Azure Functionsへの転送中にエラーが発生しました:', error);

throw error; // 再試行のために例外をスローする

}

}

return { statusCode: 200, body: JSON.stringify({ status: 'success' }) };

};マルチクラウド環境でのイベント駆動アーキテクチャを実装する際の主なパターンとして、以下が挙げられます:

クラウド間イベントブリッジパターン: 各クラウドのイベントバスやメッセージキューを連携させて、クラウドの境界を越えたイベント連携を実現します。例えば、AWS EventBridgeとAzure Event Gridを連携させるなどの方法があります。

パブリッシュ/サブスクライブパターン: クラウドに依存しない共通のメッセージブローカー(Apache Kafka、RabbitMQ、Redis Pub/Subなど)を使用して、異なるクラウド間でのイベント配信を行います。

APIゲートウェイ連携パターン: 各クラウドのAPIゲートウェイを介して、HTTPリクエスト/レスポンスベースでのイベント交換を行います。

イベント駆動アーキテクチャの利点は、各クラウド内のコンポーネントが独立して開発・デプロイできることにあります。また、一方のクラウドで障害が発生しても、イベントは一時的にキューイングされ、復旧後に処理を再開できるため、システム全体の回復力が高まります。

クラウド間連携のための効果的な統合パターン

マルチクラウド環境では、クラウド間の効果的な統合が重要です。以下に、実践的な統合パターンを紹介します:

- APIファサードパターン

各クラウドのサービスをAPIで抽象化し、クライアントやサービスコンシューマーに統一されたインターフェースを提供するパターンです。

// TypeScriptでのAPIファサードの例

export class StorageService {

private awsProvider: AwsStorageAdapter;

private azureProvider: AzureStorageAdapter;

private primaryProvider: 'aws' | 'azure';

constructor(config: StorageConfig) {

this.awsProvider = new AwsStorageAdapter(config.aws);

this.azureProvider = new AzureStorageAdapter(config.azure);

this.primaryProvider = config.primaryProvider || 'aws';

}

async uploadFile(fileName: string, data: Buffer): Promise<string> {

try {

// プライマリプロバイダを優先的に使用

if (this.primaryProvider === 'aws') {

return await this.awsProvider.upload(fileName, data);

} else {

return await this.azureProvider.upload(fileName, data);

}

} catch (error) {

console.error(`Primary provider ${this.primaryProvider} failed:`, error);

// フェイルオーバー:別のプロバイダを使用

if (this.primaryProvider === 'aws') {

return await this.azureProvider.upload(fileName, data);

} else {

return await this.awsProvider.upload(fileName, data);

}

}

}

// その他のメソッド...

}- コマンドクエリ責務分離(CQRS)パターン

データの書き込み(コマンド)と読み取り(クエリ)を別々のサービスに分離するパターンです。マルチクラウド環境では、書き込みをAWSで処理し、読み取りをGCP上の分析特化サービスで行うといった構成が可能です。

- サーキットブレーカーパターン

クラウド間の通信に障害が発生した際、システムの安定性を維持するために一時的に連携を遮断するパターンです。

// Node.jsサーキットブレーカーパターンの実装例

const CircuitBreaker = require('opossum');

function callAzureFunction(data) {

return axios.post('https://azure-function-url.azurewebsites.net/api/process', data);

}

// サーキットブレーカーを設定

const breaker = new CircuitBreaker(callAzureFunction, {

timeout: 3000, // 3秒でタイムアウト

resetTimeout: 30000, // 30秒後に再試行

errorThresholdPercentage: 50, // 50%のエラーでサーキットオープン

volumeThreshold: 10 // 最低10回の呼び出し後に判定開始

});

// フォールバック処理を設定

breaker.fallback(() => {

// Azure Functionsが利用できない場合のフォールバック動作

console.log('Azure Functions呼び出しに失敗、ローカル処理に切り替えます');

return localProcessing(data);

});

// イベントリスナー

breaker.on('open', () => console.log('サーキットがオープンしました - Azureサービスへの呼び出しを停止します'));

breaker.on('close', () => console.log('サーキットがクローズしました - Azureサービスへの呼び出しを再開します'));

breaker.on('halfOpen', () => console.log('サーキットが半オープン状態です - Azureサービスへの試験的呼び出しを行います'));- データレプリケーションパターン

クラウド間でデータを複製することで、可用性とパフォーマンスを向上させるパターンです。例えば、主要データはAWSのDynamoDBに保存し、読み取り専用レプリカをAzure Cosmos DBに複製するといった構成が考えられます。

マルチクラウドサーバーレスアーキテクチャの設計においては、単一クラウドの場合と比較して設計の複雑さが増すことは避けられません。しかし、「複雑さは本質的なものと偶発的なものがある」と言われるように、適切なパターンを採用することで偶発的な複雑さを最小限に抑え、本質的な複雑さにのみ対処することが重要です。

このトピックはこちらの書籍で勉強するのがおすすめ!

この記事の内容をさらに深く理解したい方におすすめの一冊です。実践的な知識を身につけたい方は、ぜひチェックしてみてください!

マルチクラウドサーバーレス環境の実装とデプロイ戦略

マルチクラウド環境でのサーバーレスアプリケーションの実装とデプロイは、単一クラウド環境と比較して複雑になります。しかし、適切なツールと方法論を使用することで、この複雑さを管理可能なレベルに抑えることができます。

Infrastructure as Codeを活用した環境構築の自動化

マルチクラウド環境において、手動での環境構築はミスを招きやすく、再現性にも欠けます。Infrastructure as Code(IaC)を活用することで、一貫性のある環境構築と管理が可能になります。

マルチクラウド環境でのIaC実装例:

# Terraform構成ファイルの例(main.tf)

# マルチクラウド環境の定義

terraform {

required_providers {

aws = {

source = "hashicorp/aws"

version = "~> 4.0"

}

azurerm = {

source = "hashicorp/azurerm"

version = "~> 3.0"

}

}

}

# AWSプロバイダーの設定

provider "aws" {

region = "ap-northeast-1"

}

# Azureプロバイダーの設定

provider "azurerm" {

features {}

}

# AWS Lambda関数のリソース定義

resource "aws_lambda_function" "data_processor" {

function_name = "data-processor"

handler = "index.handler"

runtime = "nodejs16.x"

role = aws_iam_role.lambda_exec.arn

filename = "lambda_function_payload.zip"

environment {

variables = {

AZURE_FUNCTION_URL = azurerm_function_app.visualization.default_hostname

}

}

}

# Azure Functions アプリのリソース定義

resource "azurerm_function_app" "visualization" {

name = "visualization-function"

location = azurerm_resource_group.main.location

resource_group_name = azurerm_resource_group.main.name

app_service_plan_id = azurerm_app_service_plan.main.id

storage_account_name = azurerm_storage_account.main.name

storage_account_access_key = azurerm_storage_account.main.primary_access_key

app_settings = {

"AWS_LAMBDA_ARN" = aws_lambda_function.data_processor.arn

}

}

# クラウド間の通信を許可するためのAWS IAMポリシー

resource "aws_iam_policy" "azure_communication" {

name = "azure-communication"

description = "Allows Lambda function to communicate with Azure Functions"

policy = jsonencode({

Version = "2012-10-17"

Statement = [

{

Action = ["execute-api:Invoke"]

Effect = "Allow"

Resource = "*"

}

]

})

}

# 出力値の定義

output "aws_lambda_function_url" {

value = aws_lambda_function.data_processor.function_url

}

output "azure_function_url" {

value = "https://${azurerm_function_app.visualization.default_hostname}/api/processData"

}マルチクラウド環境でのIaC活用のベストプラクティス:

クラウドに依存しないツールの選択: TerraformやPulumi等、複数のクラウドプロバイダーをサポートするツールを使用することで、単一のコードベースから異なるクラウド環境を管理できます。

モジュール化と再利用性: 共通のインフラストラクチャパターンをモジュール化し、各クラウド環境で再利用することで、コードの重複を避けられます。

変数とパラメータの分離: 環境固有の設定を変数として分離し、同じコードベースを異なる環境(開発、テスト、本番)に適用できるようにします。

状態管理の一元化: Terraformの状態ファイルなどを安全に管理し、チーム間で共有することで、環境の一貫性を保ちます。

クラウド間の依存関係の明示化: あるクラウドのリソースが別のクラウドのリソースに依存する場合、その関係を明示的にコードで表現します。

「Infrastructure as Codeは、バイオリンの弦のようなものだ。最初は調整が難しいが、一度マスターすれば美しい音楽を奏でることができる」と例えられるように、IaCの導入初期には学習コストがかかりますが、長期的には大きな効率化をもたらします。

CI/CDパイプラインの構築と運用のベストプラクティス

マルチクラウド環境でのCI/CDパイプラインは、単一クラウドの場合よりも複雑になりますが、適切な設計により効率的な開発ワークフローを実現できます。

マルチクラウド対応CI/CDパイプラインの例(GitHub Actions):

# .github/workflows/multi-cloud-deploy.yml

name: Multi-Cloud Serverless Deployment

on:

push:

branches: [ main ]

pull_request:

branches: [ main ]

jobs:

test:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Node.js

uses: actions/setup-node@v3

with:

node-version: '16'

- name: Install dependencies

run: npm ci

- name: Run tests

run: npm test

deploy-aws:

needs: test

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Node.js

uses: actions/setup-node@v3

with:

node-version: '16'

- name: Configure AWS credentials

uses: aws-actions/configure-aws-credentials@v2

with:

aws-access-key-id: ${{ secrets.AWS_ACCESS_KEY_ID }}

aws-secret-access-key: ${{ secrets.AWS_SECRET_ACCESS_KEY }}

aws-region: ap-northeast-1

- name: Deploy to AWS

run: |

npm ci

npx serverless deploy --stage prod --aws-profile default

deploy-azure:

needs: test

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Node.js

uses: actions/setup-node@v3

with:

node-version: '16'

- name: Login to Azure

uses: azure/login@v1

with:

creds: ${{ secrets.AZURE_CREDENTIALS }}

- name: Deploy to Azure Functions

uses: azure/functions-action@v1

with:

app-name: 'my-function-app'

package: './azure-function'

publish-profile: ${{ secrets.AZURE_FUNCTIONAPP_PUBLISH_PROFILE }}

post-deployment-integration:

needs: [deploy-aws, deploy-azure]

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Terraform

uses: hashicorp/setup-terraform@v2

- name: Update cross-cloud integrations

run: |

terraform init

terraform apply -auto-approve \

-var="aws_lambda_name=my-lambda-function" \

-var="azure_function_name=my-function-app"マルチクラウドCI/CDのベストプラクティス:

環境の一貫性: 開発、テスト、本番環境が全てのクラウドプロバイダーで同じ構成になるようにします。

並列デプロイメント: 各クラウドへのデプロイを並列に実行し、全体のデプロイ時間を短縮します。

統合テスト: マルチクラウド間の連携を検証する統合テストを実装します。例えば、AWS LambdaがAzure Functionsを正しく呼び出せるか確認するテストなどです。

ロールバック戦略: デプロイに失敗した場合、全てのクラウド環境を以前の安定した状態に戻す仕組みを用意します。

シークレット管理: 各クラウドのアクセスキーや資格情報を安全に管理し、CI/CDパイプラインで使用できるようにします。

アーティファクトの一元管理: ビルド成果物を一元的に管理し、同じバイナリが各クラウドにデプロイされるようにします。

マルチクラウド環境では、「一貫性のあるプロセスが成功の鍵」です。自動化されたCI/CDパイプラインを適切に設計することで、複雑なマルチクラウドサーバーレス環境であっても、安定した継続的デリバリーを実現できます。

このトピックはこちらの書籍で勉強するのがおすすめ!

この記事の内容をさらに深く理解したい方におすすめの一冊です。実践的な知識を身につけたい方は、ぜひチェックしてみてください!

マルチクラウドサーバーレスのモニタリングと運用戦略

マルチクラウドサーバーレス環境の運用においては、複数のクラウドプロバイダーにまたがるリソースを一元的に監視し、効率的に管理することが重要です。単一クラウドとは異なる課題に対応するための戦略を考えていきましょう。

分散環境での統合監視アプローチ

マルチクラウド環境では、各クラウドプロバイダーが提供する独自のモニタリングツール(AWS CloudWatch、Azure Monitor、Google Cloud Monitoring)だけでは全体像を把握することが困難です。そこで、クラウド間で統合されたモニタリング体制を構築する必要があります。

統合モニタリングの実装例(Node.js):

// 統合モニタリングのための共通ライブラリ

const OpenTelemetry = require('@opentelemetry/sdk-node');

const { Resource } = require('@opentelemetry/resources');

const { SemanticResourceAttributes } = require('@opentelemetry/semantic-conventions');

const { ConsoleSpanExporter } = require('@opentelemetry/sdk-trace-base');

const { NodeTracerProvider } = require('@opentelemetry/sdk-trace-node');

// OpenTelemetryを初期化

function initializeMonitoring(serviceName, environment) {

const provider = new NodeTracerProvider({

resource: new Resource({

[SemanticResourceAttributes.SERVICE_NAME]: serviceName,

'environment': environment,

'cloud.provider': 'multi-cloud'

})

});

// 必要に応じてエクスポーターを設定

// (例: Jaeger, Zipkin, Prometheus等)

const exporter = new ConsoleSpanExporter();

provider.addSpanProcessor(new SimpleSpanProcessor(exporter));

provider.register();

return provider;

}

// AWSとAzureの両方の関数でこの共通ライブラリを使用

// Lambda関数内で使用

exports.handler = async (event) => {

const tracer = initializeMonitoring('data-processor', 'production');

const span = tracer.startSpan('processData');

try {

// ビジネスロジックを実行

const result = await processData(event);

span.setStatus({ code: SpanStatusCode.OK });

return result;

} catch (error) {

span.setStatus({

code: SpanStatusCode.ERROR,

message: error.message

});

throw error;

} finally {

span.end();

}

};マルチクラウド環境における効果的なモニタリング戦略:

中央集権的な監視プラットフォームの採用:

- Datadog, New Relic, Dynatraceなどのマルチクラウド対応の監視ツールを使用

- Grafana + Prometheusの組み合わせによるオープンソースソリューションの導入

- OpenTelemetryによる標準化された計装の実装

分散トレーシングの実装:

- クラウドの境界を越えたリクエストの追跡

- 共通の相関IDによるエンド・ツー・エンドのトレーサビリティの確保

- パフォーマンスのボトルネックの特定とトラブルシューティング

統合ログ管理:

- 全てのクラウドのログを中央のログ管理システムに集約

- ELK Stack(Elasticsearch, Logstash, Kibana)やLokiなどの活用

- 構造化ロギングによる検索と分析の効率化

// 構造化ロギングの例

function logEvent(level, message, data, correlationId) {

const logEntry = JSON.stringify({

timestamp: new Date().toISOString(),

level,

message,

correlationId,

environment: process.env.ENVIRONMENT,

service: process.env.SERVICE_NAME,

cloud: process.env.CLOUD_PROVIDER,

region: process.env.REGION,

...data

});

console.log(logEntry);

// 必要に応じて中央ロギングシステムに送信

if (level === 'error' || level === 'warn') {

sendToCentralLoggingSystem(logEntry);

}

}アラートの一元管理:

- 重複アラートの抑制と統合

- インシデント管理ツール(PagerDuty, OpsGenie等)との連携

- クラウド間のエスカレーションポリシーの一貫性確保

ヘルスチェックとSLO監視:

- クラウド間のエンドポイントの可用性監視

- SLI(Service Level Indicators)の計測と記録

- SLA(Service Level Agreements)遵守の自動チェック

「全てを見ることなしに、何も制御することはできない」という言葉があるように、マルチクラウド環境では統合された可視性が運用成功の鍵となります。

コスト最適化とパフォーマンスチューニングの実践テクニック

マルチクラウドサーバーレス環境では、コストとパフォーマンスのバランスを取りながら最適化を進めることが重要です。各クラウドのコスト構造やパフォーマンス特性を理解し、適切な調整を行いましょう。

コスト分析と最適化の例(コスト追跡スクリプト):

// AWS LambdaとAzure Functionsのコストを分析するスクリプト

const AWS = require('aws-sdk');

const { DefaultAzureCredential } = require('@azure/identity');

const { CostManagementClient } = require('@azure/arm-costmanagement');

async function analyzeMultiCloudCosts() {

// AWS コスト取得

const cloudwatch = new AWS.CloudWatch();

const lambda = new AWS.Lambda();

const lambdaFunctions = await lambda.listFunctions().promise();

const functionMetrics = [];

for (const func of lambdaFunctions.Functions) {

// 過去30日間の呼び出し回数と実行時間の取得

const invocations = await cloudwatch.getMetricStatistics({

Namespace: 'AWS/Lambda',

MetricName: 'Invocations',

Dimensions: [{ Name: 'FunctionName', Value: func.FunctionName }],

StartTime: new Date(Date.now() - 30 * 24 * 60 * 60 * 1000),

EndTime: new Date(),

Period: 2592000, // 30日間

Statistics: ['Sum']

}).promise();

const duration = await cloudwatch.getMetricStatistics({

Namespace: 'AWS/Lambda',

MetricName: 'Duration',

Dimensions: [{ Name: 'FunctionName', Value: func.FunctionName }],

StartTime: new Date(Date.now() - 30 * 24 * 60 * 60 * 1000),

EndTime: new Date(),

Period: 2592000,

Statistics: ['Average', 'Sum']

}).promise();

// コスト計算

const totalInvocations = invocations.Datapoints[0]?.Sum || 0;

const totalDurationMs = duration.Datapoints[0]?.Sum || 0;

const totalDurationSec = totalDurationMs / 1000;

const memorySize = func.MemorySize;

// コスト計算(リージョン別の料金を適宜調整)

const invocationCost = totalInvocations * 0.0000002; // $0.20 per 1M requests

const durationCost = (totalDurationSec / 1000) * (memorySize / 1024) * 0.0000166667; // $0.0000166667 per GB-second

functionMetrics.push({

functionName: func.FunctionName,

provider: 'AWS',

invocations: totalInvocations,

avgDuration: duration.Datapoints[0]?.Average || 0,

totalDuration: totalDurationSec,

memorySize,

invocationCost,

durationCost,

totalCost: invocationCost + durationCost

});

}

// Azure コスト取得(Azure Cost Management API使用)

const credential = new DefaultAzureCredential();

const costClient = new CostManagementClient(credential, subscriptionId);

const queryRequest = {

type: 'Usage',

timeframe: 'MonthToDate',

dataset: {

granularity: 'None',

aggregation: {

totalCost: {

name: 'PreTaxCost',

function: 'Sum'

}

},

grouping: [

{

type: 'Dimension',

name: 'ResourceId'

}

]

}

};

const result = await costClient.query.usage(subscriptionId, queryRequest);

// 結果を処理してコスト効率の悪い関数を特定

const inefficientFunctions = functionMetrics

.filter(fn => fn.avgDuration > 1000 || fn.totalCost > 10)

.sort((a, b) => b.totalCost - a.totalCost);

return {

awsFunctions: functionMetrics,

azureCosts: result,

inefficientFunctions,

optimizationSuggestions: generateOptimizationSuggestions(inefficientFunctions)

};

}

function generateOptimizationSuggestions(functions) {

// 最適化の提案を生成

return functions.map(fn => {

const suggestions = [];

if (fn.avgDuration > 3000) {

suggestions.push(`関数 ${fn.functionName} の実行時間(${fn.avgDuration}ms)が長いため、パフォーマンスの最適化を検討してください。`);

}

if (fn.memorySize > 512 && fn.avgDuration < 500) {

suggestions.push(`関数 ${fn.functionName} のメモリサイズ(${fn.memorySize}MB)を減らすことでコスト削減できる可能性があります。`);

}

return {

functionName: fn.functionName,

provider: fn.provider,

totalCost: fn.totalCost,

suggestions

};

});

}マルチクラウドサーバーレス環境でのコスト最適化とパフォーマンスチューニングのベストプラクティス:

関数の設定最適化:

- メモリ割り当ての適切な調整(パフォーマンスとコストのバランス)

- コールドスタート削減のためのプロビジョニングされたコンカレンシーの活用

- 実行時間の最適化と効率的なコード実装

トラフィックパターンに応じた適切なクラウド選択:

- コスト効率の高いクラウドへのトラフィック誘導

- リージョン別の料金差を考慮したデプロイ戦略

- スポットインスタンスやリザーブドキャパシティの活用

無駄なリソースの排除:

- 未使用または低使用率の関数の特定と削除

- 不要なデータ転送の最小化

- ログ保持期間の最適化

自動スケーリングとスロットリング:

- ピーク時のコスト急増を防ぐためのレート制限

- バースト処理のためのキューイングの活用

- コスト上限の設定と監視アラート

定期的なコスト分析とベンチマーク:

- 週次/月次のコストレビュー

- クラウド間のパフォーマンス/コスト比較

- クラウドプロバイダー間での最適な負荷分散の調整

イタリアの経済学者パレートの法則に倣えば、「サーバーレスの支出の80%は、関数の20%から生じる」ことがよくあります。効果的なモニタリングとコスト分析により、この20%の高コスト関数を特定し、最適化することで大きな効果を得ることができます。

マルチクラウドサーバーレス環境の運用においては、可視性と最適化の継続的なサイクルを回すことが成功の鍵です。クラウド間の違いを理解し、それぞれの強みを活かしながら、全体としての効率性と信頼性を高めていきましょう。

このトピックはこちらの書籍で勉強するのがおすすめ!

この記事の内容をさらに深く理解したい方におすすめの一冊です。実践的な知識を身につけたい方は、ぜひチェックしてみてください!

おすすめコンテンツ

2025/5/14

2025/5/14【2025年最新】LLMファインチューニング効率化ガイド:コスト削減と精度向上を両立する実践テクニック

大規模言語モデル(LLM)のファインチューニングは、特定の用途に合わせてAIモデルを最適化する強力な手法ですが、多くの開発者がコスト、計算資源、精度のバランスに苦労しています。本記事では、最小限のデー...

続きを読む 2025/5/4

2025/5/4「サーバーレスって何?」初心者でもわかる入門ガイド!クラウド時代の効率的な開発手法

サーバーレスアーキテクチャの基本から実践的な活用法まで初心者にもわかりやすく解説。AWS Lambda、Google Cloud Functions、Azureの具体的な使用例とベネフィットを紹介しま...

続きを読む 2025/5/14

2025/5/14クリーンアーキテクチャ完全ガイド!正しい理解と実装方法

クリーンアーキテクチャとは何か、その本質的な考え方と実際のコード実装方法について解説します。レイヤー分けの重要性や名前に囚われない柔軟な適用方法、実際のプロジェクトへの導入ステップまで、初心者にもわか...

続きを読む 2025/5/14

2025/5/14GraphQLとRESTの使い分け完全ガイド:APIアーキテクチャの選択を最適化する方法

GraphQLとRESTの違いを理解し、プロジェクトに最適なAPIアーキテクチャを選択するための完全ガイド。両方の長所と短所、実装コストを比較し、適切な使い分け方を解説します。

続きを読む 2025/5/15

2025/5/15クラウドネイティブアプリケーション開発完全ガイド:2025年最新のベストプラクティス

モダンなクラウドネイティブアプリケーション開発の全てを解説。マイクロサービス、コンテナ、CI/CD、オブザーバビリティの実装方法と、スケーラブルで堅牢なアプリケーションを構築するためのベストプラクティ...

続きを読む 2025/5/14

2025/5/14GraphQLクエリ最適化完全ガイド!パフォーマンス向上のための実践テクニック

GraphQLを使ったアプリケーションのパフォーマンスを向上させるためのクエリ最適化テクニックを初心者にもわかりやすく解説します。N+1問題の解決からキャッシュ戦略まで、実践的なコード例と共に学べます...

続きを読む 2025/5/5

2025/5/5【2025年最新】マイクロフロントエンド入門:モダンWebアプリケーションのための実践的アーキテクチャ設計

マイクロフロントエンドはフロントエンド開発を効率化する先進的なアーキテクチャアプローチです。この記事では、マイクロフロントエンドの基本概念から実装パターン、実践的な導入手順まで、初心者にもわかりやすく...

続きを読む 2025/5/14

2025/5/14Cloudflareインフラストラクチャ完全ガイド 2025年最新版

Cloudflareのグローバルネットワーク、エッジコンピューティング、セキュリティ機能、開発者向けサービスを網羅的に解説。最新のCloudflare Workers、D1、R2、Queuesなどのサ...

続きを読む

![Ansible実践ガイド 第4版[基礎編] impress top gearシリーズ](https://m.media-amazon.com/images/I/516W+QJKg1L._SL500_.jpg)